《科创板日报》12月23日讯(编辑 宋子乔) 有着“AI教母”之称的斯坦福大学教授李飞飞又有新发现——尽管空间推理能力依然薄弱,但多模态大模型已经能够记住和回忆空间,甚至内部已经形成了局部世界模型,表现出了空间意识。

来自纽约大学、耶鲁大学、斯坦福大学的研究者引入了VSI-Bench,这是一个用于评估多模态大模型视觉空间智能能力的工具。VSI-Bench包含了超过5000个问答对,这些问答对来源于288个真实视频。这些视频包括居住空间、专业场所(例如,办公室、实验室)和工业场所(例如,工厂)——以及多个地理区域。VSI-Bench的质量很高,经过迭代审查以最小化问题的歧义,并移除了从源数据集中传播的错误注释。

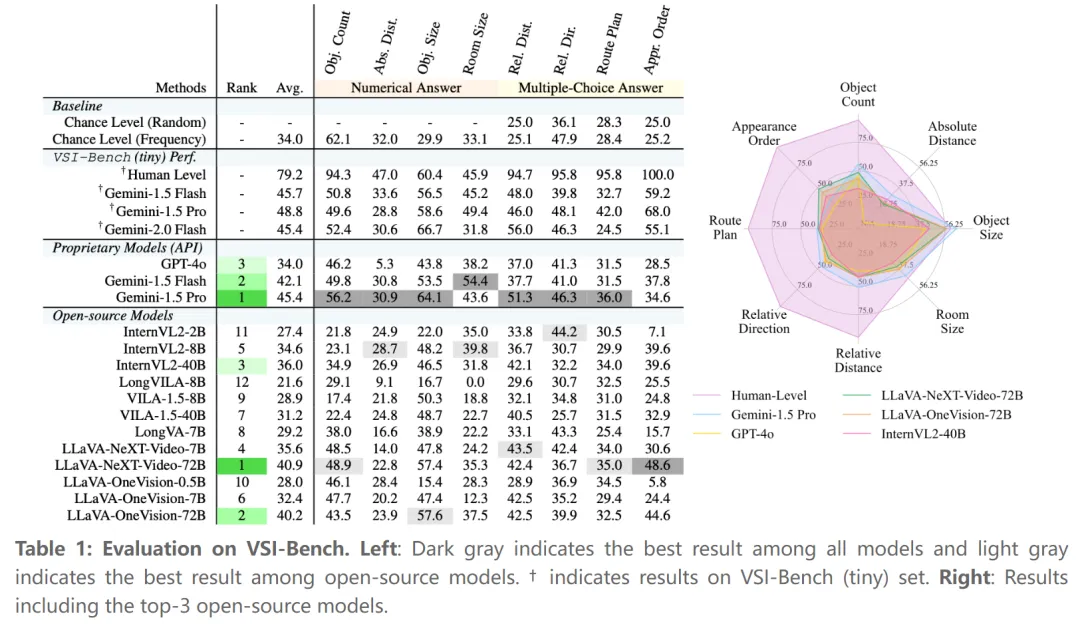

通过5000多个问答对,研究人员发现多模态大模型表现出了有竞争性的视觉空间智能(尽管仍然低于人类)——人类评估者的平均准确率达到79%,比最佳模型高出33%,在配置和时空任务上的表现接近完美(94%-100%)。

哪些模型的空间智能能力更强?

在专有模型中,Gemini-1.5 Pro脱颖而出,尽管只在2D数字数据上进行训练,但它大大超过了机会基线,并在绝对距离和房间大小估计等任务中接近人类表现;表现最佳的开源模型,如LLaVA-NeXT-Video-72B和LLaVA-OneVision-72B,取得了有竞争力的结果,仅落后Gemini-1.5 Pro 4%-5%。然而,大多数开源模型(7/12)都低于机会基线,暴露出视觉空间智能的明显缺陷。

在最新研究中,研究人员还给出了提升大模型空间智能能力的潜在路径。

这项研究系统评估了多模态大模型的视觉空间智能后发现,思维链、思维树、自洽性等常用的语言提示技术不仅没有提升模型在空间任务上的表现,反而会使性能下降,而问答过程中明确生成认知地图则会增强多模态大模型的空间距离能力——使用认知地图辅助空间推理,可使模型在空间任务上的准确率提升了10个百分点。

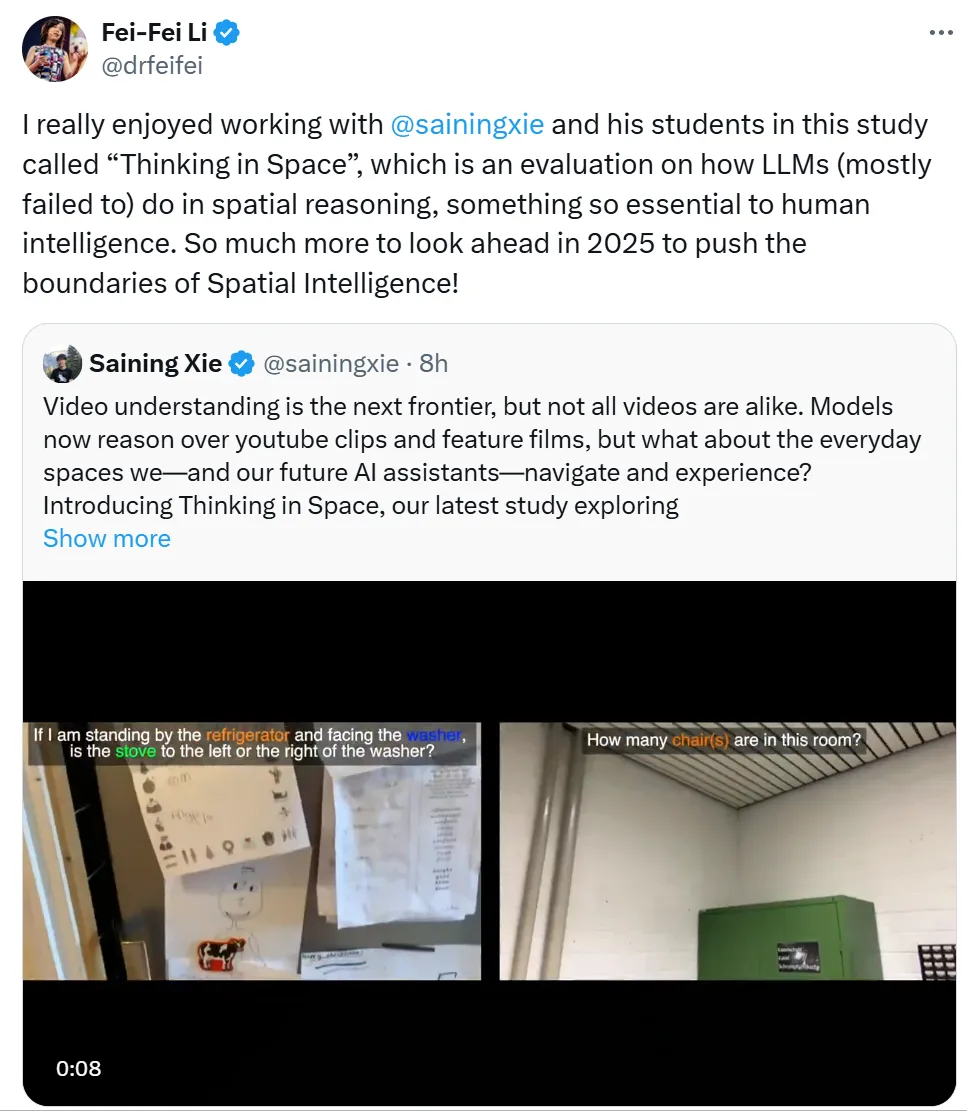

相关论文已发布,合著作者中不仅有李飞飞,还有纽约大学计算机科学助理教授、CV大牛谢赛宁。

谢赛宁表示,视觉空间智能在现实世界中的应用,比以往任何时候都更近了。比如AI眼镜,它可以向我们显示去过的地方,还能定位、导航。

李飞飞也表示,在2025年,空间智能的界限很可能会再次突破,“这项名为“Thinking in Space”的研究,是对大模型在空间推理方面表现的评估,而空间推理对人类智能至关重要。”

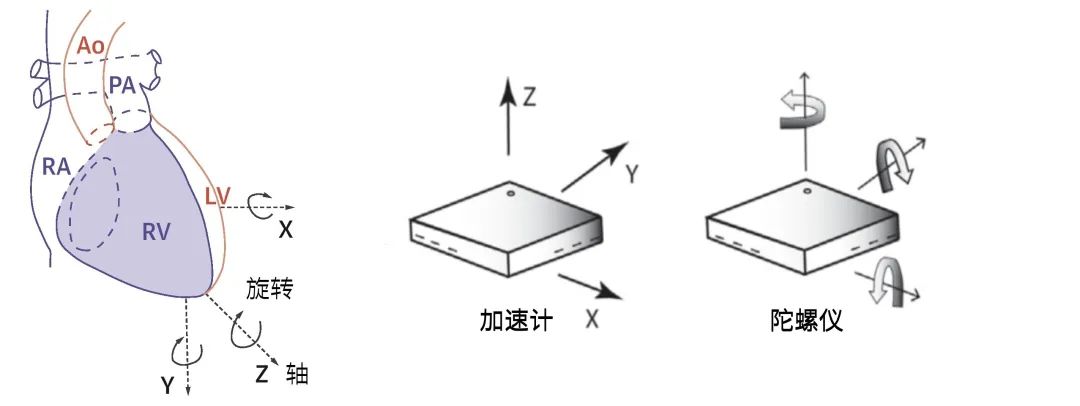

视频理解能力无疑是AI大模型的下一个待攻关高地。当前的多模态大模型在2D空间的推理能力不断增强,可以较好地处理语言对话任务和视频图像任务,但在空间认知和理解方面的能力仍未得到充分研究。

空间智能对于模型理解物理世界而言至关重要。

李飞飞对空间智能的定义是:空间智能是机器在3D空间和时间中感知、推理和行动的能力。

在她看来,空间智能是AI领域的下一个前沿技术方向,是她的下一个“北极星”。

李飞飞此前表示,实现AGI(通用人工智能)的关键一环是“空间智能”,尽管OpenAI的Sora模型可以文生视频,但就本质而言,它仍属平面二维模型,没有三维立体理解能力,只有通过空间智能,才能看到世界、感知世界、理解世界并让机器人做事,从而形成良性闭环。

今年9月份,在成功融资2.3亿美元后,李飞飞创办的空间智能公司World Labs正式启动。据介绍,World Labs的目标是开发一种能够理解实体世界的模型。今年7月,有消息称在完成两轮融资后,World Labs的估值已超过10亿美元,该公司的投资机构可以说是耳熟能详,包括安德森•霍罗威茨(Andreessen Horowitz,又名a16z)、Adobe、AMD、Databricks、英伟达、AI基金Radical Ventures等。