Mac 用户,终于不用羡慕 N 卡玩家有专属大模型 Chat with RTX 了!大神推出的新框架,让苹果电脑也跑起了本地大模型,而且只要两行代码就能完成部署。

仿照 Chat with RTX,框架的名字就叫 Chat with MLX(MLX 是苹果机器学习框架),由一名 OpenAI 前员工打造。

黄院士的框架里有的功能,例如本地文档总结、YouTube 视频分析,Chat with MLX 里也都有。

而且包括中文在内共有 11 种可用语言,自带支持的开源大模型多达七种。

体验过的用户表示,虽然计算量负担对苹果设备可能大了点,但是新手也很容易上手,Chat with MLX 真的是个好东西。

那么,Chat with MLX 的实际效果究竟怎么样呢?

用 MacBook 部署本地大模型

Chat with MLX 已经集成到了 pip 命令中,所以在有 pip 的条件下,只需要一行代码就能完成安装:

pip install chat-with-mlx

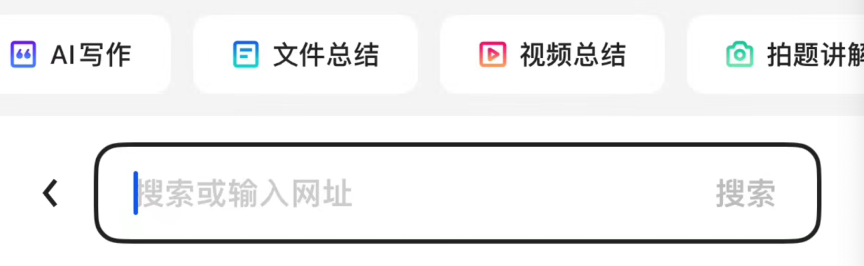

安装完成后,在终端中输入 chat-with-mlx 并按回车,就会自动完成初始化并弹出网页(第一次启动及下载模型时需要连接到 Hugging Face 服务器)。

将这个页面向下翻,选择想用的模型和语言后点击 Load Model,系统就会自动下载模型信息并加载。

注意如果中途需要更换模型,需要先将前面的模型 Unload 再选择新模型。

其他模型只要 Hugging Face 上有并且兼容 MLX 框架,也可以手工添加,方法可以到 GitHub 页中了解。

如果要使用自有数据,需要先选择类型(文件或 YouTube 视频),然后上传文件或填写视频链接,并点击 Start Indexing 建立索引。

按照开发者的说法,只要不点击 Stop,再次上传新文件后数据是累加的。当然,也可以不传数据,直接当成普通大模型来用。

为了避免推理时间过长,我们选择了规模较小的 Quyen-SE 来进行测试。

(Quyen-SE 基于阿里的通义千问改造而成,Chat with MLX 的作者也参与了研发工作。)

首先看看模型不加定制数据的速度,在 M1 芯片的 MacBook 上,这个 0.5B 的模型表现是这样的,可以说比较流畅。

但在宣传中,Chat with MLX 的主要卖点,还是本地 RAG 检索。为了确保素材文档在模型的训练数据中不存在,小编从箱底翻出了自己不公开上网的本科毕业论文。

我们询问了论文中不同位置的细节,一共根据文章内容给 Chat with MLX 设计了十个问题。

其中有七个回答是正确(符合文意)的,不过速度和纯生成相比要略慢一些。

测试中我们还发现,模型还有一定的几率会把提示词吐出来,不过触发条件似乎没有什么规律。

但可以看出,为了提高模型的表现,作者已经把给小费这种新兴的提示词技巧都招呼上了。

整体感受下来,可能是受制于算力原因,在苹果设备上部署本地大模型,效果无法和英伟达的 Chat with RTX 相媲美。

同时,在 GitHub 上,也有许多用户反馈各种各样的安装失败问题,作者也都进行了回复或跟进,并把程序重新更新了一遍。

但无论如何,选择本地化部署,数据的安全性可能是更为重要的考量因素;而且从中可以看出,本地化、专属化的大模型,已经开始出现向消费级产品普及的趋势。

用网友的话说,升级 AI PC 的时间到了。

GitHub:

-

https://github.com/qnguyen3/chat-with-mlx

本文来自微信公众号:量子位 (ID:QbitAI),作者:克雷西