让 Kimi Chat 学完了整本周易,给 Sam Altman 算了一卦|AI 鲜测

文章来源:硅星GenAI

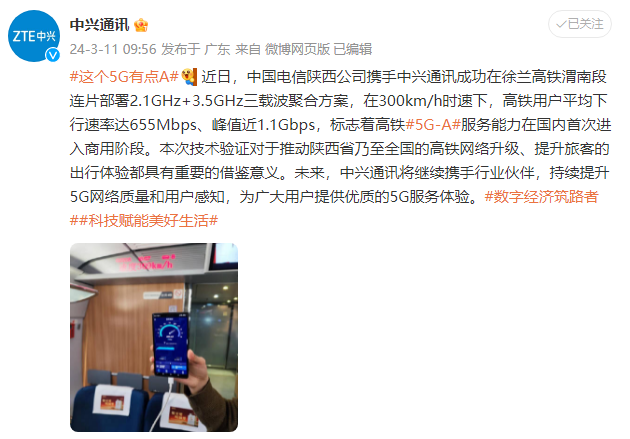

最近,Kimi Chat 的上下文长度从 20 万汉字升级到了 200 万汉字,10 倍的差距已经足够产生一次质变,做很多之前做不了的事情。

感谢月之暗面给了提前测试的机会,我们直接开测!

小伙伴可以上手试试啦!

场景1:做SEO(搜索引擎优化)!

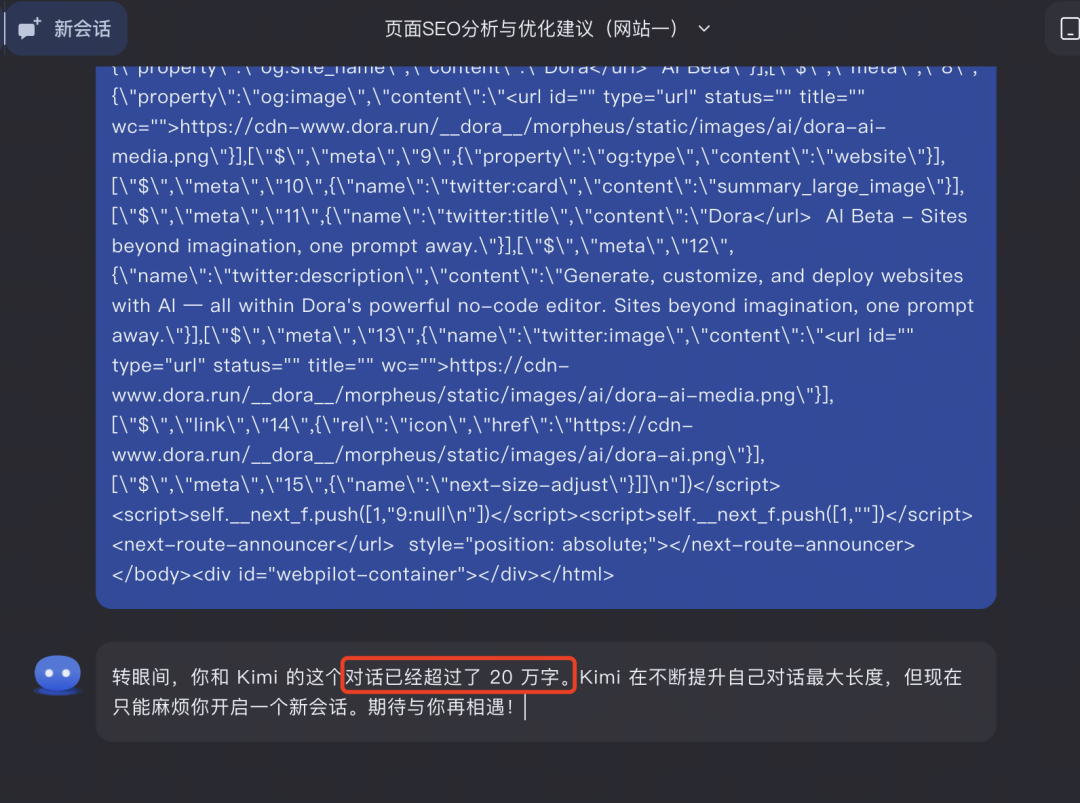

第一轮测试用的是常规20万上下文窗口,输入了两段网页代码,显然两轮对话已经超出20万上下文。

这时候 200 万汉字的上下文长度的优势就显现出来了,直接转到200万字上下文入口重新提问,如果按照刚刚对话的 token 数量来算的话,目前至少能支持10轮及以上的对话。

20万上下文对话窗口:分两次输入两段代码直接超出20w

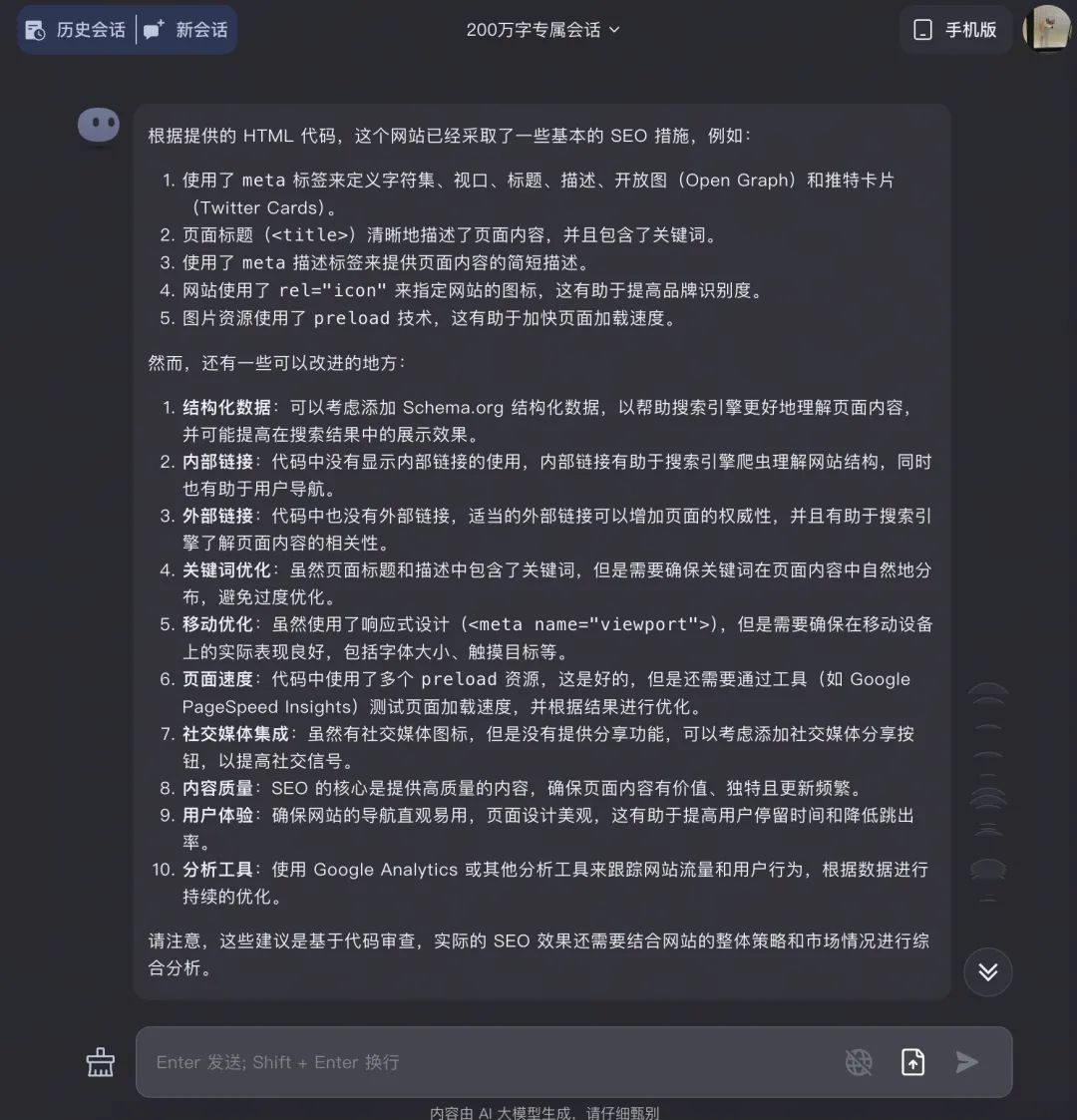

第二轮测试:用200万窗口测试,这种持续连贯对话的感觉简直太爽了!

直接复制刚才的代码到200万窗口,它可一点儿没含糊,不停地持续回答和输出。然后直接问 Kimi 这个网站有啥可以改进的,它给了大概框架。

200万上下文对话窗口:超级无限长的代码10万字段儿,足足划了半分钟才到头儿

但我想要的是具体细致的建议,

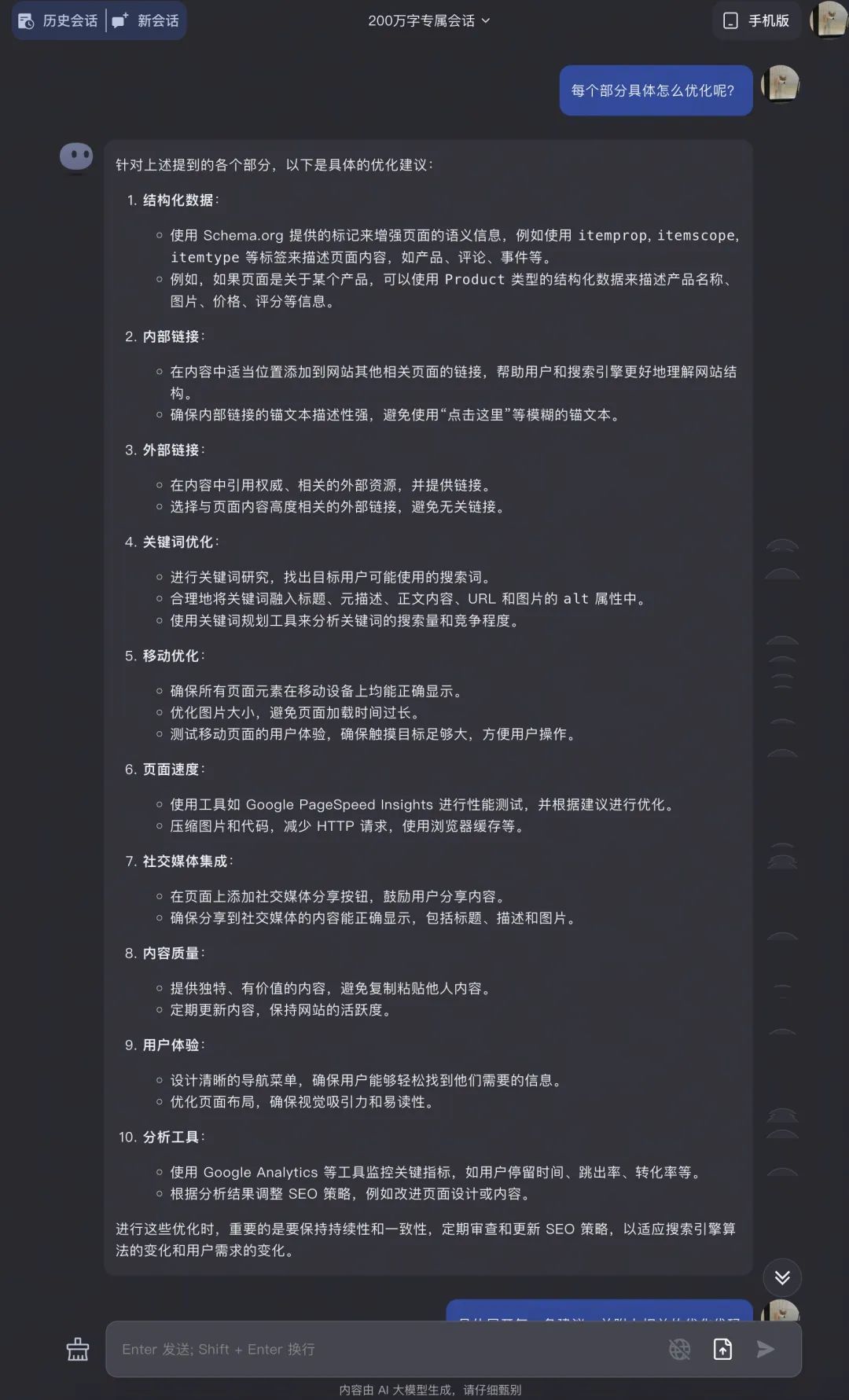

接下来我又问它,具体有什么可以优化的地方;

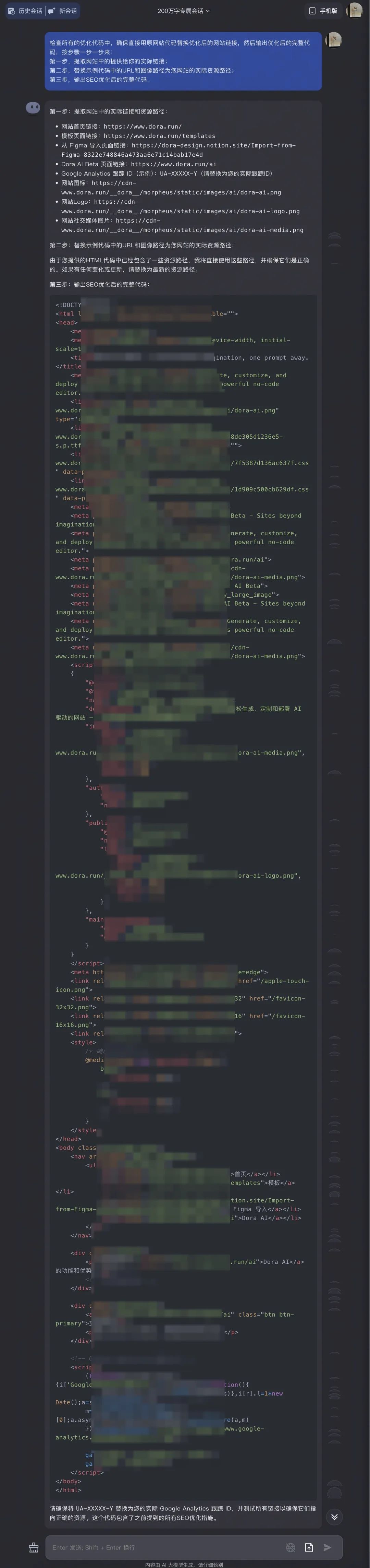

在这两次对话中,网站 SEO 优化建议是有了,但是我需要的是具体能够运行的代码,接下来测测它到底能否理解我的要求并给出相关的代码;

在回答具体建议时 Kimi 展开了每一条,优化的地方有十几处,Kimi 逐个给出了 SEO 优化建议及代码示例。(代码实在太长了就不一一展开了)

但是也有一个缺点:就是每次输出内容篇幅有限,又不能直接生成 PDF,就只能手动不停地点“继续、继续、继续......”

到这里之后,在元数据上进行优化,大方向上不会破坏原来的内容,Kimi 这点理解的还是挺到位的!在优化上甚至还多加了一些我没考虑到的点,十分周到。

在前几次的回答中仍然不太满意,我想要的是最终在原数据上优化后的代码,于是再次要求它;

从理解能力和连贯性来看,Kimi 每次回答都能相对准确地联系上下文,同时给出相应的建议,可见它在长文本连贯性上是蛮强的!

现在我们来实际看一下,优化SEO网站之后的实际效果到底如何?

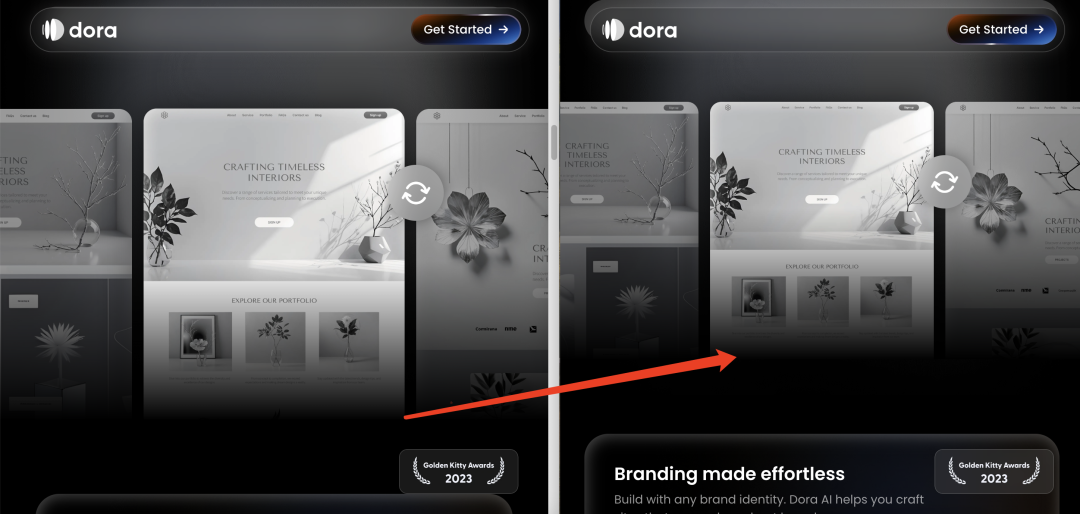

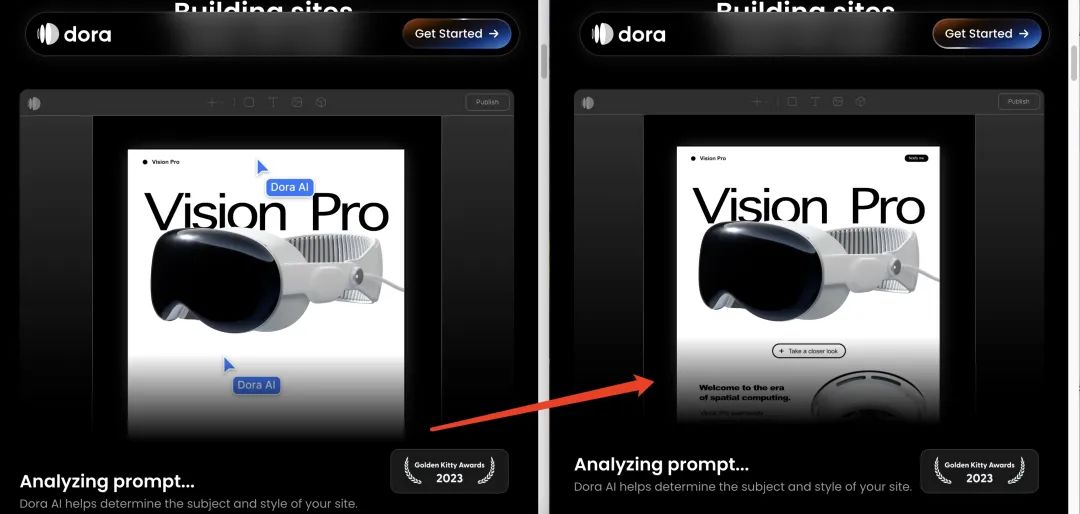

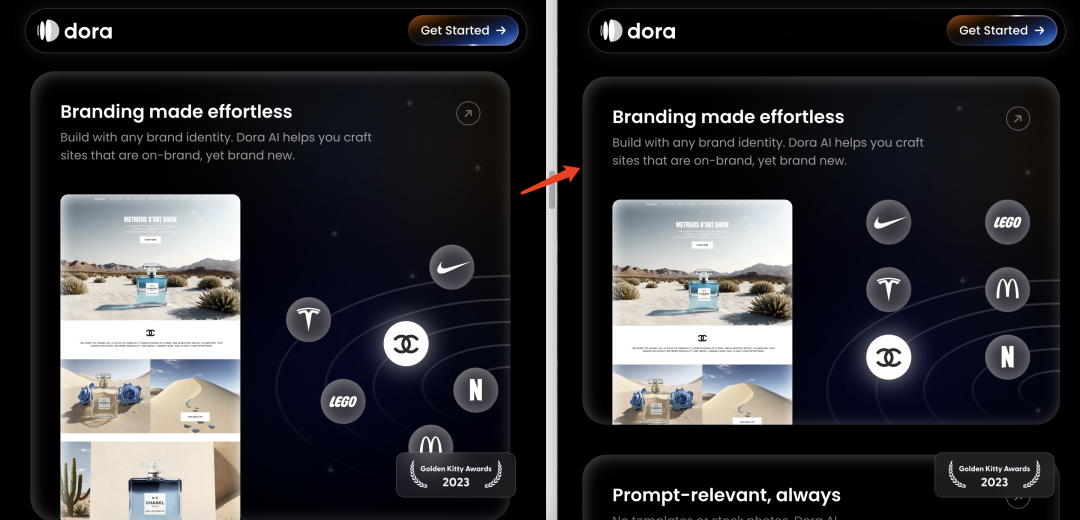

这次对话对网站的 SEO 优化最直观体现在这三个地方:

第一,图片和视频在网页中的占比有所调整。比如第一个视频整体变小,第二张图也变的稍微小一些;

(PS:左为原网站,右为优化 SEO 后的网站)

第二,页面整体布局更加协调,更加符合视觉习惯,对比着看确实舒服不少。

第三,网页文字内容优化,在原来的基础上优化了网页里呈现的文字内容,

场景2:我用《周易》给奥特曼算了一卦!

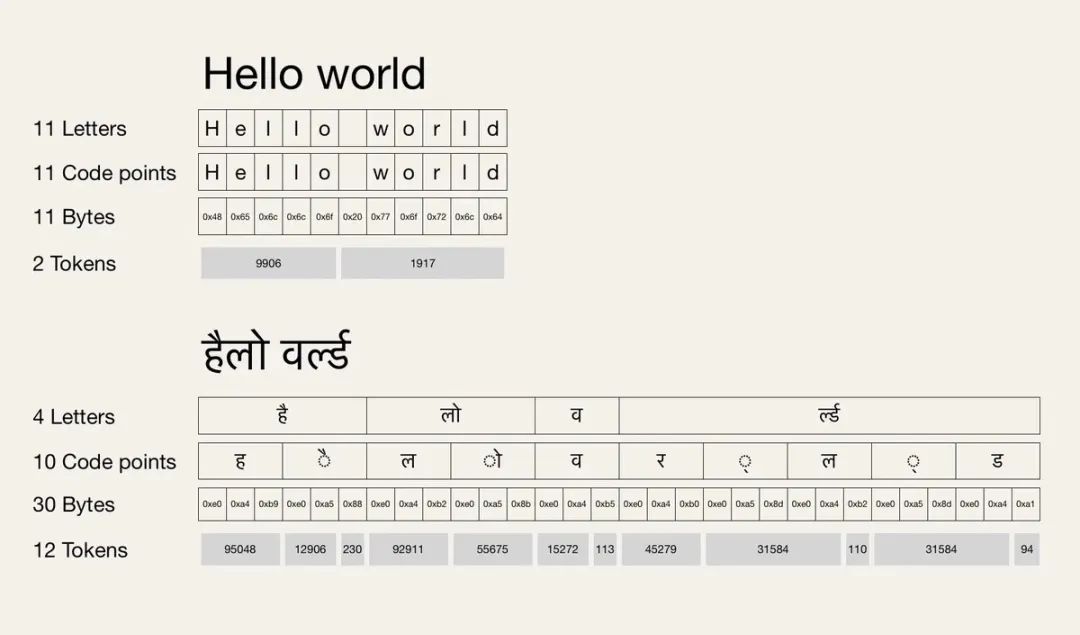

大型语言模型处理古文字与处理现代英文的差异时,一个显著的区别在于所需的编码单元或'token'的数量。古文字,如《周易》中的八卦符号,每个符号可能需要一个或多个 tokens 来准确表示其丰富的意义和历史背景,因为这些符号往往蕴含着比现代字母更复杂的概念。相比之下,现代英文文字则相对简单,通常每个字符对应一个token,因为它们的语义和形式更直接、更线性。

图片源自网络

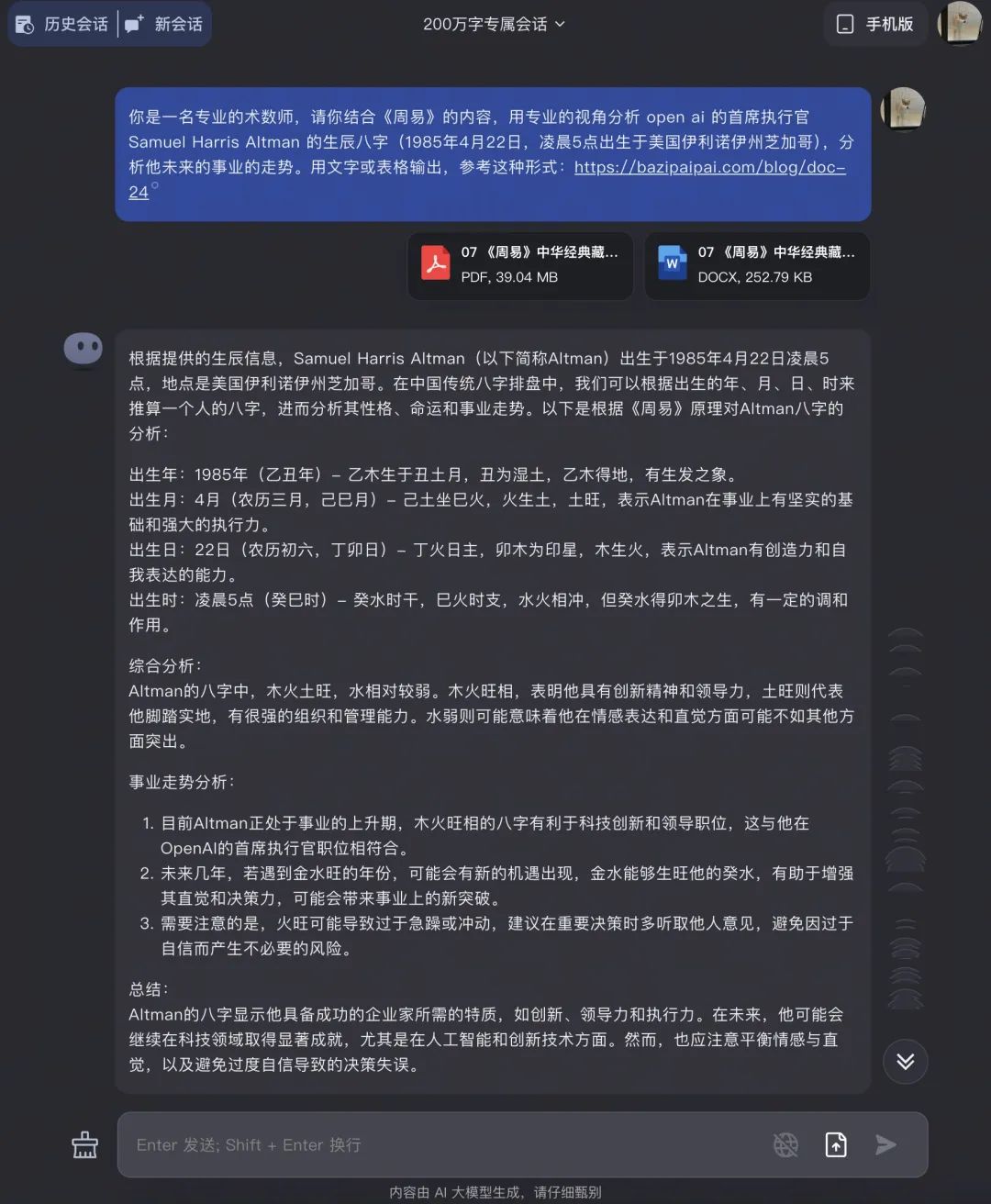

基于此,我就借用咱们的经典《周易》给奥特曼先生算一卦,看看 Kimi 在解读《周易》古文字上的效果如何。

我先是上传了中华经典《周易》典藏本,和奥特曼的生辰八字(约莫准确?)

图片由 Midjourney 生成

从第一次回答中,能看出 Kimi 在解读古文字时说的头头是道,像模像样。让我们继续深入看看它到底专业不?

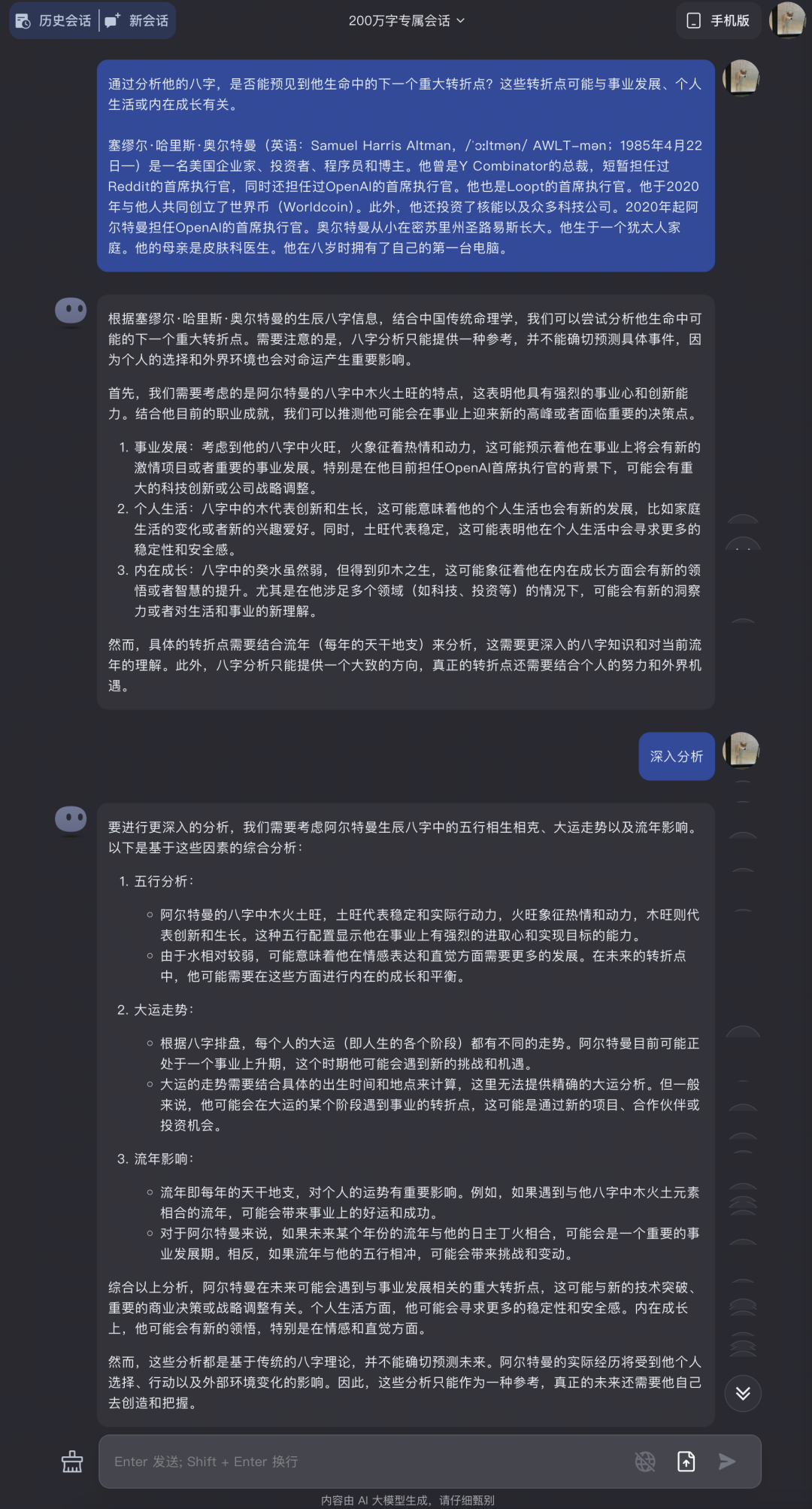

接下来我又给出奥特曼的一些生平履历,

Kimi 一开始的回答很浅很浅,都没啥意思;

但提醒它深入分析后,还是很浅!!

看来《周易》这种难啃的古文字对 Kimi 来说还是挺有难度的。

场景3:我用 Kimi 啃专业论文!

原本是想根据个人一年的工作材料,让 Kimi 写一个年终报告,但是现在三月份,还没到那时候呢!

那如果是论文呢?

如果它连大几十的论文都啃得动,能理解并且连续输出重新写一篇新的论文,个人年终总结更是不在话下!

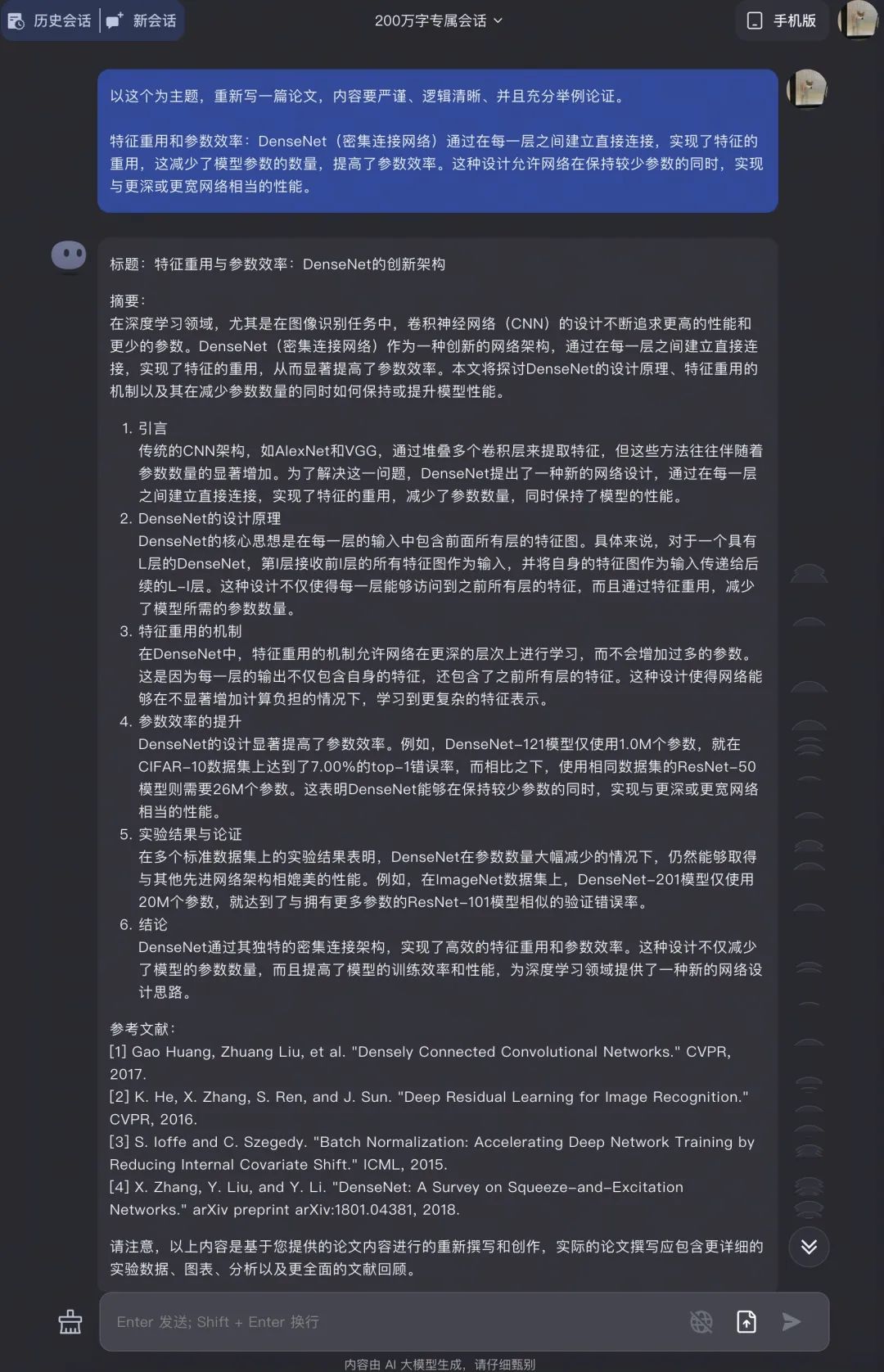

下面我上传了31份 AI 相关的热门论文,kimi 能从大量晦涩难懂的论文中,迅速分析并输出新的论文大纲,大纲内容角度还挺全面。

这部分不仅提炼出了新的主题,同时用中英文对照的方式写了出来,还列出表格对比了新旧论文的主要观点。

最初想法是写一篇论文,那自然要看看他能提出哪些独到的观点,看他是否真的理解了这些论文的内容,然后从这些观点中选择一个主题写出论文大纲;

接下来就是撰写正文了,对于 Kimi 输出内容质量倒是没那么担心,不过 Kimi 有个缺点是每一次的输出篇幅偏短,想要让它一次写长论文,基本没可能。倒是 Kimi 自己在结尾也提醒到了“篇幅有限”这一点。

如果想要更精细的内容,更好的办法是把论文大纲拆分成小章节单独扩写,才能达到想要的效果。

这个测试极大地体现出来 Kimi 对于上下文的高度连续性,对于工作中处理大量的文献以及资料 十分方便,尤其是想要提取特定的信息的时候。

通过这次测试,最大的感受是:上下文带来不仅仅 AI 的学习能力,更重要的是让 AI 的耐力更强,我们可以持续进行多轮对话。

超长文本输入+持续的多轮对话能力,我们在一个对话中就能将 AI 微调成我们需要的样子。

月之暗面创始人 杨植麟认为:“所有问题都是文本长度的问题。如果你有10亿的 context length(上下文长度),今天看到的问题都不是问题。”

对于长文本来说更重要的是 lossless,也就是输入的信息不随着文本长度增加而损失。某种程度上,绝对的文本长度是花架子,无损压缩的能力才能分模型的胜负。

月之暗面方面透露,这次上下文长度从20万字扩展到200万字由于没有采用常规的渐进式提升路线,研发和技术团队遇到的技术难度也是指数级增加的。为了达到更好的⻓窗口无损压缩性能,团队从模型预训练到对⻬、推理环节均进行了原生的重新设计和开发。

期待月之暗面 10 亿上下文的那一天,也欢迎各位读者将自己使用 Kimi Chat的经验和心得分享给我们, 探索200 万汉字的潜力到底在哪里。

免责声明:

1.资讯内容不构成投资建议,投资者应独立决策并自行承担风险

2.本文版权归属原作所有,仅代表作者本人观点,不代币币情的观点或立场